Una teoria “too big to fail”: la supersimmetria e la crisi della fisica

Gli abbagli nella scienza sono piuttosto comuni. Gli scienziati, in fin dei conti, sono esseri umani, come tali soggetti ai bias cognitivi che li portano a prediligere quei dati o quelle teorie in accordo con le loro intime convinzioni. Giovanni Schiapparelli si convinse di aver visto dei canali artificiali su Marte, benché una spiegazione di origine naturale fosse la più ovvia; i fisici dell’esperimento OPERA che decisero di annunciare l’eclatante e poi ritrattata scoperta dei neutrini superluminali nel 2011 ignorarono completamente la possibilità di un semplice difetto della strumentazione; i cosmologi che annunciarono nel 2014 la scoperta di onde gravitazionali primordiali nella radiazione cosmica di fondo non presero in considerazione l’influenza della polvere cosmica nella misurazione, che in effetti era la vera spiegazione di quanto osservato.

Qualcosa del genere è avvenuto anche all’ultimo convegno internazionale dei fisici delle alte energie tenutosi a Chicago dal 3 al 10 agosto scorso, in cui i rappresentanti degli esperimenti ATLAS e CMS del Cern di Ginevra hanno presentato i dati accumulati nel corso degli ultimi mesi di collisioni nell’acceleratore di particelle LHC, che funziona ora quasi al massimo della sua energia, pari a 13 TeV (teraelettronvolt). Tutta l’attenzione era rivolta alla conferma o meno di uno strano segnale prodotto dalle collisioni all’energia di 750 GeV, coerente con l’esistenza di una particella sconosciuta e del tutto imprevista a quel livello di energia.

Nei mesi scorsi, sulla base dei primi dati relativi a questo segnale, che sembrava statisticamente piuttosto solido (una possibilità su 10.000 che si trattasse di un errore, o – come si dice in gergo – di una “fluttuazione statistica”), i fisici teorici hanno scritto più di 500 paper per cercare di far rientrare questo risultato sperimentale all’interno di una cornice teorica coerente. La conferenza stampa di ATLAS e CMS a Chicago ha invece rivelato che il segnale a 750 GeV scompare nei nuovi dati, confermando la fluttuazione statistica. Molto rumore per nulla, ma tutto sommato non è successo niente di grave: semplicemente qualcuno ha perso un po’ di tempo a elucubrare su qualcosa che semplicemente non esisteva.

Il discorso è ben diverso se si guarda all’altra notizia deludente emersa dal convegno di Chicago, in gran parte oscurata dalla prima: ancora una volta, l’acceleratore LHC non ha visto nessuna nuova particella tra quelle previste dalla teoria della supersimmetria, che da tempo rappresenta la più accreditata teoria “oltre il Modello Standard” nella fisica delle particelle (e non solo). Qui sta il problema che sta producendo quella che diversi osservatori ormai chiamano apertamente la “grande crisi della fisica”.

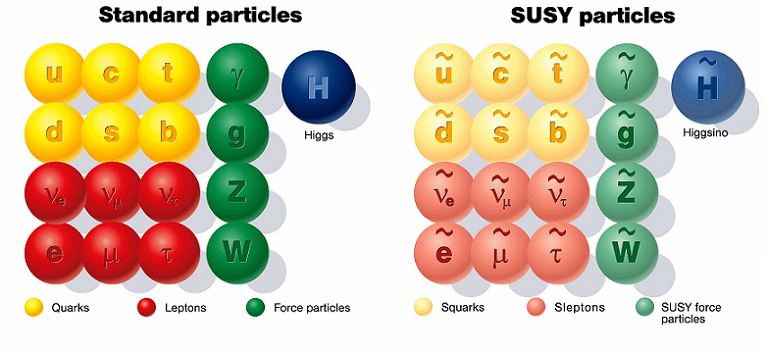

La supersimmetria è infatti il paradigma dominante della fisica teorica contemporanea. Come ricorda nel suo libro The Cosmic Landscape (2006) uno dei suoi tanti sostenitori, Leonard Susskind, “dalla metà degli anni Settanta la stragrande maggioranza degli articoli di fisica delle particelle elementari ha in qualche modo a che fare con la supersimmetria”. La teoria prevede sostanzialmente l’esistenza di una simmetria tra le due grandi famiglie in cui si dividono le particelle elementari, i fermioni e i bosoni. La famiglia dei fermioni è composta da tutti i costituenti della materia – quark (che formano i neutroni e i protoni), elettroni e neutrini – ed è caratterizzata dal fatto che tutte le particelle hanno spin semintero (cioè una frazione di un numero intero); la famiglia dei bosoni è composta dalle particelle mediatrici delle forze fondamentali, ossia i fotoni (per l’elettromagnetismo), i gluoni (per la forza nucleare forte), i bosoni W e Z (per la forza nucleare debole) e gli ipotetici gravitoni (per la forza gravitazionale), tutte con spin intero. Apparentemente non hanno nulla in comune, ma diversi fisici nei decenni passati sospettavano che ci fosse invece qualche collegamento tra di esse, spinti dall’inclinazione mentale a cercare sempre un principio unitario laddove esiste invece apparente molteplicità.

La proposta della supersimmetria sostiene che fermioni e bosoni possiedono dei “partner” simmetrici, con identiche proprietà: quelli dei fermioni sono gli squark, i selettroni e gli sneutrini, che hanno spin intero come i bosoni (nello specifico hanno spin zero), mentre i partner dei bosoni sono i fotini, i gluini, i wini, gli zini ed eventualmente i gravitini, che hanno spin semintero come i fermioni (nello specifico hanno spin ½, tranne il gravitino che dovrebbe essere 3/2). La cosa appare quantomeno bizzarra, soprattutto per un fatto evidente: se questa nuova pletora di particelle esistesse davvero, le avremmo già viste da tempo, perché se la simmetria è vera allora dovrebbero avere la stessa massa dei loro partner ordinari. Ma la simmetria, sostengono i teorici, non è perfetta, è “rotta”: le particelle della supersimmetria hanno le stesse proprietà di quelle ordinarie, ma massa diversa, nello specifico qualche centinaio di volte la massa del protone (da qui l’aggettivo “super”). Per vederle, dovremmo cercarle attraverso potenti acceleratori di particelle.

Fig. 1 – Le particelle a sinistra sono quelle previste dal Modello Standard e verificate negli acceleratori di particelle. Quelle a destra sono i loro presunti partner supersimmetrici.

Prima ancora di poter mettere alla prova questa teoria, i fisici hanno iniziato a convincersi della sua validità da un punto di vista puramente teorico. L’esistenza di partner supersimmetrici dei bosoni e dei fermioni risolve numerosi problemi. Il primo e più importante riguarda la teorie delle stringhe, la principale proposta della fisica teorica per unire i due grandi paradigmi, la meccanica quantistica e la relatività generale, ossia per ottenere una versione “quantizzata” della forza gravitazionale, che invece sembra irriducibile alla meccanica quantistica. La teoria delle stringhe si fonda sull’idea che tutte le particelle fondamentali siano semplicemente l’espressione di modi di vibrazione di stringhe (corde) unidimensionali.

Questa straordinaria teoria, da cui emerge in modo naturale la relatività generale, si è candidata dalla metà degli anni Ottanta come la più promettente “teoria del tutto”, ma funziona solo se si accetta l’ipotesi della simmetria tra le due famiglie di particelle: inizialmente, infatti, la teoria delle stringhe si applicava solo ai bosoni, creando un evidente problema, dal momento che la teoria non può funzionare se i bosoni sono stringhe e i fermioni sono particelle. La supersimmetria risolve il problema. Per usare le parole di Lisa Randall: “Senza la supersimmetria, la teoria delle stringhe parrebbe incapace di descrivere il nostro universo”. Secondo Brian Greene, tra i principali stringhisti contemporanei: “Se la teoria delle stringhe è corretta, allora ci si aspetta che lo sia anche la supersimmetria”.

Ma non è solo questo, anche se già sarebbe un problema, perché la teoria delle stringhe si è imposta ormai da decenni come la più importante proposta teorica della fisica delle particelle. I fisici hanno man mano cercato di applicare l’ipotesi supersimmetrica a tutta una serie di altri problemi. Uno di questi è relativi alle GUT, le teorie di grande unificazione (Grand Unification Theories) che cercano di dimostrare che tre delle quattro forze fondamentali (esclusa la gravità) sono in realtà espressione di un’unica grande forza esistente nei primi istanti dopo il Big Bang, quando le temperature dell’universo erano elevatissime. I calcoli dimostrano che in effetti all’aumentare delle temperature le differenze oggi notevoli tra queste tre forze vengono meno, eppure non al punto da portarle a coincidere perfettamente, il che appare strano. Considerando invece i contributi delle interazioni tra particelle supersimmetriche, ecco che l’unificazione diventa realtà.

Un altro problema risolto elegantemente dalla supersimmetria è relativo alla massa del bosone di Higgs, che oggi sappiamo essere 125 GeV, come le teorie più o meno predicevano. È davvero strano che la massa di Higgs sia così piccola, tutto sommato, perché questa dovrebbe tener conto dei contributi quantistici delle particelle più pesanti, in particolare il quark top, con cui il bosone interagisce con maggiore preferenza. Queste particelle “appesantirebbero” l’Higgs fino a fargli raggiungere una massa enorme, incompatibile con il Modello Standard (e quindi con la fisica alla base della nostra stessa esistenza). La supersimmetria prevede però che i fermioni diano un contributo quantistico positivo alla massa, negativo invece per i bosoni. Per ogni quark top c’è quindi uno squark stop che elimina “l’appesantimento”.

Fig. 2 – In assenza di supersimmetria, le tre forze descritte dalla meccanica quantistica (elettromagnetismo, nucleare debole e nucleare forte) non possono essere descritte come tre aspetti di un’unica superforza esistita all’inizio dell’universo. Tenendo conto delle interazioni supersimmetriche (a destra), si osserva invece sul piano teorico una convergenza perfetta delle tre forze all’aumentare dell’energia.

Questo meccanismo sorprendentemente efficace, che risolve il problema della massa del bosone di Higgs, risolverebbe inoltre uno dei più grandi rompicapi della cosmologia, quello dell’energia oscura, che sappiamo essere responsabile dell’accelerazione del tasso di espansione dell’universo. Le teorie più accreditate al riguardo sostengono che l’energia oscura sia il prodotto dell’energia del vuoto, prodotta dalle interazioni tra le particelle virtuali che compaiono e scompaiono continuamente negli spazi vuoti del cosmo e previste dalla meccanica quantistica. Il campo gravitazionale prodotto dall’energia del vuoto avrebbe un effetto repulsivo, non attrattivo, causando quel fenomeno che osserviamo a livello cosmologico, ossia l’allontanarsi reciproco di stelle, galassie e ammassi.

Il problema è che il contributo delle particelle virtuali del vuoto cosmico è tale che il valore dell’energia prodotta dovrebbe essere altissimo, pari a 10116 joule, tale che l’universo sarebbe dovuto andare in pezzi già molto tempo fa. Invece, per spiegare i fenomeni osservati, il suo valore dovrebbe essere molto piccolo, forse pari a zero. Se però consideriamo la supersimmetria, e quindi il reciproco annullamento dei contributi quantistici tra particelle ordinarie e partner supersimmetrici, ecco che il valore dell’energia del vuoto è pari praticamente a zero, come vorrebbe la teoria. La supersimmetria non è quindi solo alla base della moderna fisica delle particelle e delle alte energia, ma anche della cosmologia. Ciò diventa ancor più evidente quando si passa al problema della materia oscura, ossia di quella “massa mancante” dell’universo che sappiamo esistere perché esercita un’attrazione gravitazionale sulle galassie, ma non possiamo vede perché “oscura”, in quanto non emette radiazione elettromagnetica. Eppure la materia oscura costituisce circa il 90% della massa dell’universo!

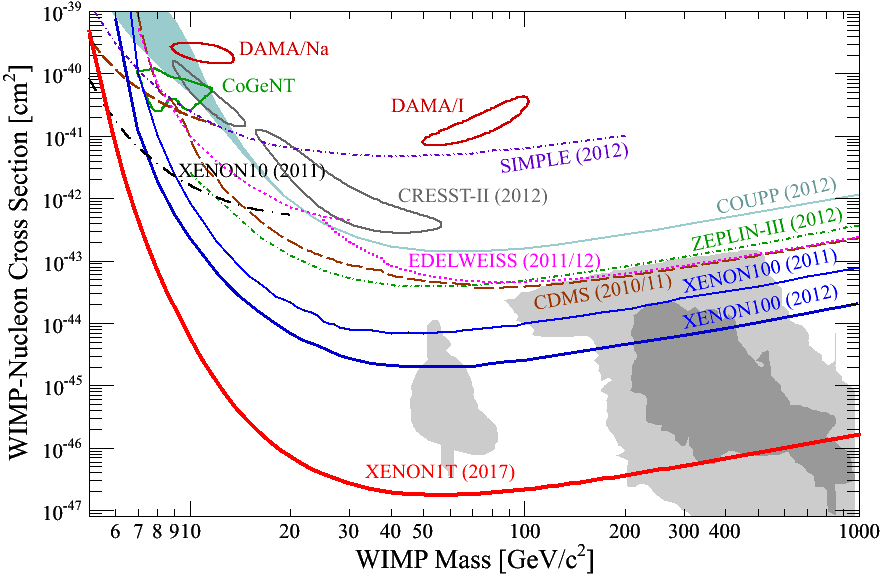

Le teorie più accreditate su cui si fondano tutti gli attuali esperimenti impegnati nella caccia alla materia oscura si servono della supersimmetria: prevedono infatti che il responsabile della materia oscura sia una particella, o una famiglia di particelle, dette WIMPs (Weakly Interacting Massive Particles, ossia particelle massive debolmente interagenti), che non interagiscono quasi per niente con la materia ordinaria e tuttavia sono dotate di grande massa, e che sarebbero composte di particelle supersimmetriche. L’indiziato numero uno su cui si concentrano le ricerche è il “neutralino”, un’ipotetica particella composta da un fotino, uno zino e due higgsini, rispettivamente partner supersimmetrici del fotone, del bosone Z e del bosone di Higgs.

Fin qui la teoria. Il dramma viene dopo. “Se la supersimmetria è un’ipotesi corretta, la vedremo presto confermata”, scriveva nel lontano 2005 Lisa Randall nel suo libro Warped Passages. Dieci anni fa, Leonard Susskind affermava che la scoperta delle particelle supersimmetriche fosse “dietro l’angolo”. Il perché è presto detto. Secondo la teoria, i superpartner dovrebbero avere una massa qualche centinaio di volte quella del protone, che è più o meno 1 GeV. Le stime dei teorici negli anni Novanta e nei primi anni Duemila convenivano su masse tra i 100 e i 300 GeV. Per produrre negli acceleratori particelle di questa massa, basterebbe un’energia di collisione di 1 TeV (1000 GeV). Il Tevatron del Fermilab vicino Chicago era in grado di raggiungere quest’energia dalla fine degli anni Novanta e tutti si aspettavano che confermasse l’esistenza della supersimmetria ancora prima che LHC entrasse in funzione, nel 2008. Invece non è successo niente. A quel punto tutta l’attenzione si è concentrata su LHC, partito con un’energia di collisione di poco superiore ai 2 TeV (il doppio del massimo raggiunto al Tevatron) e arrivato nel 2010 a 7 Tev.

Quella del bosone di Higgs era una scoperta attesa quanto scontata. Il vero interesse dei fisici delle particelle nei confronti di LHC è sempre stato l’individuazione delle particelle previste dalla supersimmetria. Quando è stato chiaro che nemmeno a quell’energia sarebbero state prodotte, sono iniziate le prime preoccupazioni, lenite dal fatto che, al termine di un anno e mezzo di potenziamento, dagli inizi del 2015 LHC avrebbe lavorato alle energie massime previste, pari a ben 13 TeV. A quel punto ci si aspettava di vedere le superparticelle da un momento all’altro. Invece niente. A Chicago quest’agosto, dopo più di un anno di dati raccolti, è stato confermato il nulla assoluto.

Naturalmente si potrebbe sostenere che le particelle supersimmetriche debbano avere masse maggiori di quelle inizialmente previste. C’è però un problema, come spiega Guido Tonelli dell’esperimento CMS a LHC nel suo ultimo libro (La nascita imperfetta delle cose, 2016): affinché il meccanismo supersimmetrico che spiega il perché della massa dell’Higgs possa funzionare, “lo squark stop non dovrebbe avere una massa troppo più grande di quella del top, che vale circa 173 GeV”; ma se così fosse “avremmo già dovuto produrne a iosa”. Di conseguenza i teorici hanno rivisto le loro stime, non senza difficoltà, ma esiste un limite superiore: “Sappiamo già che, se non si troveranno stop più leggeri di 2 TeV, quel meccanismo di cancellazione, che si presenta così elegante, e che permette a Susy [il diminutivo utilizzato dai fisici per la supersimmetria, da SUperSYmmetry] di mantenere il suo sex appeal, non sarebbe più giustificato e Susy, quantomeno nelle versioni più comuni, entrerebbe seriamente in crisi”.

Per Susskind, il problema è relativo: “Se i superpartner non compaiono nemmeno esplorando masse cento volte più grandi di quella del protone, si dovranno rivedere le stime attuali, e costruire nuovi acceleratori che abbiano accesso a masse dell’ordine di mille, o forse diecimila masse protoniche”, scriveva nel 2006. Non tutti ne sono convinti. In un articolo del giugno 2015 pubblicato sul New York Times, dall’eloquente titolo “A Crisis at the Edge of Physics”, i fisici Adam Frank dell’Università di Rochester e Marcelo Gleister del Dartmouth College si sono chiesti fin dove ci si dovrebbe spingere nella ricerca dell’evidenza empirica di una teoria. Un dibattito filosofico, riconoscono, destinate però ad avere pesanti implicazioni nel prossimo futuro.

È vero che non si costruiscono acceleratori come LHC solo per testare la supersimmetria, e che le ricadute economiche e industriali di simili imprese sono numerose; tuttavia, un’ulteriore riflessione da parte del mondo della fisica teorica prima di cimentarsi in una nuova impresa dovrebbe essere necessaria, sostengono i due ricercatori, se la prova della supersimmetria continuasse a sfuggirci. In un articolo pubblicato nel maggio 2014 su Scientific American e intitolato, altrettanto eloquentemente, “Supersymmetry and the Crisis in Physics”, Joe Likken e Maria Spiropulu – rispettivamente fisico teorico al Fermilab e fisica sperimentale al California Institute of Technology – raccontano di un episodio in cui, durante un convegno, un fisico di Princeton dichiarò ai suoi colleghi che, se LHC non avesse trovato alcuna traccia della supersimmetria, allora si sarebbero prodotti nuovi modelli teorici nei quali i superpartner si sarebbero trovati ad avere masse al di fuori della portata degli esperimenti attuali e futuri.

Fine della fisica? La pensano così George Ellis e Joe Silk, che in un celebre editoriale pubblicato nel dicembre 2014 su Nature hanno preso posizione contro le teorie troppo speculative della fisica teorica che la sperimentazione potrebbe non riuscire mai a provare o smentire in via definitiva (tra queste, la teoria delle stringhe e il multiverso), definendole pertanto “non scientifiche”. È troppo facile, scrivono, sostenere che non esistano alternative: “Potremmo non averle ancora trovate”. Anche nel loro articolo su Scientific American, Likken e Spiropulu suggerivano di tornare a dedicare maggiore attenzione a quelle teorie alternative che il paradigma dominante della supersimmetria ha finora relegato ai margini del dibattito scientifico.

È una storia che a qualcuno suona molto simile a quella legata alla crisi economico-finanziaria del 2007-2008, dove ad andare in crisi fu il paradigma dominante del neoliberismo affermatosi negli anni Ottanta del secolo scorso e fondato sulla convinzione che non esistano alternative (il famoso acronimo TINA, “There Is No Alternative”, caro a Margaret Thatcher). In un’intervista con Susskind del 2006 pubblicata sull’Huffington Post, l’astronomo e opinionista scientifico Sten Odenwald si chiedeva se la supersimmetria e la teoria delle stringhe fossero teorie “too big to fail”, troppo importanti per poter essere considerate un mero abbaglio, impiegendo un altro termine mutuato dalla crisi del 2008. Ammettere l’inesistenza della supersimmetria avrebbe lo stesso effetto, per la fisica teorica, della bancarotta di Lehman Brothers? Non è un paragone troppo azzardato: alla domanda di Odenwald se esistano teorie concorrenti in grado di sostituire la supersimmatria e la conseguente teoria delle superstringhe, Susskind rispose: “Non che io sappia”. Questo è un bel problema.

Teorie concorrenti esistono, ma non godono di grande credito. Quelle poche volte che i sostenitori della supersimmetria e delle sue teorie derivate (le superstringhe e le WIMPs) le citano, è solo per sostenere che non sono coerenti. Lee Smolin, nel suo libro A Trouble with Physics (2006), sostiene che ciò si spieghi con il fatto che il mondo accademico americano – e di conseguenza, in buona parte, anche quello europeo – ha ostacolato lo sviluppo di nuove teorie, a causa di meccanismi che hanno poco a che fare con la scienza e molto più con la natura umana: la pratica di assumere candidati che già lavorano sulle stesse teorie su cui si concentrano le ricerche dei professori di carriera, la preferenza per i filoni di ricerca che hanno più possibilità di essere finanziati (ossia quelli più collaudati), il meccanismo bibliografico per cui è preferibile pubblicare ricerche in aree consolidate per conquistare un più alto numero di citazioni: tutto concorre a rinforzare le teorie dominanti a scapito di quelle concorrenti.

Il problema non riguarda solo la fisica delle particelle e LHC. Dal punto di vista dei mancati risultati sperimentali, l’imbarazzo di gran lunga maggiore proviene dagli esperimenti in corso per la ricerca della materia oscura. Dopo anni di ricerche, l’esperimento LUX (Large Underground Xenon experiment) realizzato nelle profondità delle miniere del South Dakota in cerca delle WIMPs, che dovrebbero essere prodotte dalle particelle supersimmetriche, non ha dato alcun risultato positivo. Ora le speranze delle centinaia di ricercatori impegnati nell’esperimento sono riposte nel suo successore, LUX-Zeplin, che sarà completato non prima del 2020. Ma ci sono altri esperimenti in corso, tra cui lo XENON1T presso i Laboratori Nazionali del Gran Sasso, attualmente il più sensibile attivo a livello mondiale. Elena Aprile, che dirige la collaborazione internazionale di XENON1T, è sicura dell’imminente risultato: in una recente intervista a D , ha dichiarato di voler “vincere la corsa alla materia oscura”, sottolineando che “adesso, grazie all’idea dello xenon, siamo in testa noi”. Eppure lo scetticismo avanza.

L’esperimento AMS-02 in orbita dal 2011 sulla Stazione Spaziale Internazionale avrebbe dovuto già da tempo rilevare indizi cosmici della presenza di neutralini, e anche in questo caso non è emerso niente. Per un programma costato 1,5 miliardi di dollari, è un bel problema. Quando andò in orbita, cinque anni fa, il suo principal investigator, Samuel Ting, era dato come uno dei prossimi premi Nobel, dal momento che tutti si attendevano un’imminente scoperta della materia oscura (nello Spazio è infatti molto più facile individuare tracce delle WIMPs). Finora, questi esperimenti sono serviti solo a stringere il cerchio, fornendo limiti alla masse teorizzata delle WIMPs. Secondo Elena Aprile, anche se XENON1T non trovasse nulla, “potrebbe fornire un range di massa per le WIMPs non ancora accessibile agli acceleratori”, pertanto “anche non osservare nulla sarebbe comunque un risultato” (http://home.infn.it/it/approfondimenti/interviste/1698-elena-aprile-intervista-a-elena-aprile-della-columbia-university-di-new-york-coordinatrice-dell-esperimento-xenon1t-inaugurato-ai-laboratori-nazionali-del-gran-sasso-lngs-dell-infn).

Fig. 3 – Numerosi esperimenti stanno tentando di individuare le WIMPs, ma al momento si sono limitati a definire i vincoli di massa di queste ipotetiche particelle. L’esperimento XENON1T si spingerà a livelli superiori a quelli di tutti i precedenti esperimenti.

Ma bisogna ammettere che è un po’ pochino. Sul suo influente blog Not Even Wrong (titolo anche di un libro tradotto in italiano nel 2007 come Neanche sbagliata, dura critica alla teoria delle stringhe), il fisico e matematico della Columbia University Peter Woit scrive che le WIMPs sono “nel braccio della morte” insieme alla supersimmetria, in attesa dell’esecuzione. In un articolo su Scientific American uscito a fine agosto, il giornalista scientifico Lee Billings definisce il problema delle WIMPs “il cuore di tenebra” della fisica. Come per le particelle supersimmetriche, di cui le WIMPs in ultima analisi sono composte, queste candidate a responsabili della materia oscura hanno guadagnato crescenti consensi negli anni perché costituiscono “una spiegazione semplice, elegante e persuasiva a un fenomeno complesso”; e tuttavia, osserva il cosmologo Edward Kolb, tra i padri della teoria delle WIMPs, “per ogni fenomeno complesso esiste una spiegazione semplice, elegante e persuasiva che è sbagliata”.

Kolb aveva definito quello degli anni ’10 “il decennio delle WIMPs”, ma si sta ricredendo. Il suo è tuttavia un caso più unico che raro. Per chi ha costruito intere carriere su teorie come la supersimmetria, l’idea di doverle abbandonare è difficile da accettare. Peggio ancora per grandi esperimenti costati centinaia di milioni o a volte miliardi di euro, che però danno lavoro a centinaia o migliaia di fisici. C’è un intero sistema che gravita intorno alla supersimmetria e questo la rende davvero una teoria “too big to fail”.

Esistono soluzioni? Nessuno sostiene che bisogna mettere fine agli esperimenti e abbandonare la teoria. Ma nella comunità dei fisici c’è poca voglia di discutere delle possibili conseguenze; un atteggiamento sbagliato che ha avuto il solo risultato di trasformare un’ipotesi teorica elegante e matematicamente coerente, ma non provata, nell’unica alternativa, nel paradigma dominante. Discutere dei meccanismi che viziano il mondo accademico e della ricerca è invece fondamentale per consentire lo sviluppo di teorie concorrenti. Magari si riveleranno tutte fallaci, mentre la supersimmetria sarà confermata nei prossimi anni. Magari si troveranno, come hanno suggerito Ellis e Silk, dei nuovi modelli esplicativi oggi sconosciuti: sta per esempio prendendo piede, dopo le prime rilevazioni delle onde gravitazionali prodotte da buchi neri primordiali, l’idea che la materia oscura, o comunque una parte significativa di essa, possa essere spiegata ipotizzando l’esistenza di un numero molto più alto di buchi neri nelle prime epoche dell’universo.

Fino a qualche anno fa nessuno ci avrebbe scommesso nulla. Secondo Sabine Hossefanfelder, che studia la gravità quantistica al Frankfurt Institute for Advanced Studies, questa e altre ipotesi non hanno ottenuto la giusta considerazione rispetto alla teoria delle WIMPS per un motivo più sociologico che scientifico: “Inventare nuove particelle è quello che i fisici delle particelle fanno per vivere; è ovvio che sia quello che preferiscono”. Il problema è stato drammaticamente sintetizzato da Lee Smolin: negli ultimi trent’anni, la fisica teorica fondamentale non ha fatto alcun passo avanti e si è rivelata incapace di spingersi oltre il Modello Standard. Le uniche grandi scoperte di questi ultimi trent’anni al di fuori del Modello Standard – la massa del neutrino e l’energia oscura – sono frutto degli esperimenti e dell’osservazione, mentre la teoria non è stata finora in grado di spiegarle efficacemente. C’è il rischio che, a furia di sostenere che “there is not alternative”, la fisica teorica si ritrovi presto in un’impasse.

“Tuttavia, io sono convinto che ogni ulteriore sviluppo verso la comprensione dei più fondamentali costituenti dell’universo richiederà l’abbandono, da parte dei fisici, delle ideologie fossilizzate della supersimmetria e della teoria delle superstringhe, che hanno dominato gli ultimi due decenni”, scriveva dieci anni fa Peter Woit al termine del suo controverso libro Neanche sbagliata. Forse siamo vicini al momento in cui bisognerà dargli ragione.